Permiso de Circulación 2026: Revisa cuánto pagarás este año

El Servicio de Impuestos Internos (SII) publicó en su sitio web la tasación de los vehículos livianos y pesados para este 2026.

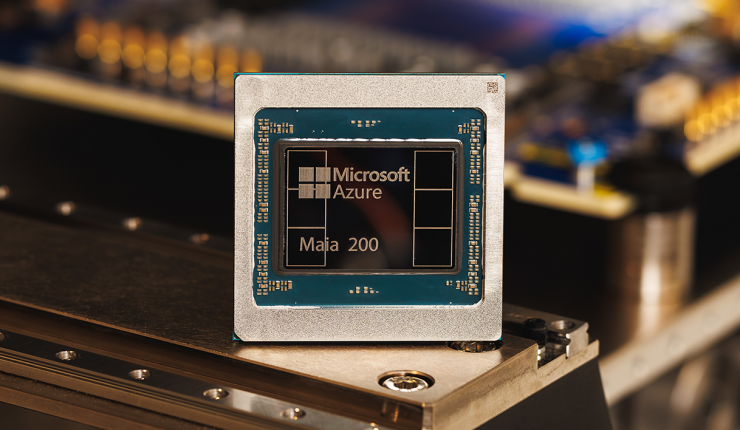

Este lunes Microsoft presentó la segunda generación de su chip con el que busca mejorar su ubicación en la carrera de chips de IA y reducir la dependencia de Nvidia.

Maia 200 es el nombre de la segunda generación de chips de inteligencia artificial desarrollados por Microsoft. Desde la compañía presentaron el chip como: “El acelerador de IA diseñado para la inferencia”.

“Nos enorgullece presentar Maia 200, un acelerador de inferencia revolucionario diseñado para mejorar de manera importante la economía de la generación de tokens con IA”, dijeron desde la empresa.

El chip, diseñado para maximizar el uso de la nube, busca optimizar el rendimiento de las cargas de trabajo más exigentes, como el próximo modelo de ChatGPT, el GPT-5.2 de OpenAI.

Asimismo, con esta nueva generación, Microsoft busca reducir su dependencia de Nvidia y competir contra Google y Amazon en el almacenamiento en la nube.

Scott Guthrie, vicepresidente ejecutivo de Microsoft Cloud + IA, sostuvo que “es el sistema de inferencia más eficiente que Microsoft ha desplegado jamás“.

El Maia 200 viene a suceder al Maia 100, la primera versión de este chip que no llegó a estar a la venta al público.

Desde Microsoft detallaron que el Maia 200 contiene más de 140 mil millones de transistores y está adaptado para cargas de trabajo de IA a gran escala. “En términos prácticos, Maia 200 puede correr sin esfuerzo los modelos más grandes de hoy, con mucho margen para modelos aún más grandes en el futuro”.

Por otra parte, dieron a conocer las especificaciones técnicas del Maia 200.

Además, Microsoft tomó como referencia los chips de Amazon y Google para comparar la potencia del Maia 200. “El Maia 200 es tres veces el rendimiento FP4 del Amazon Train de tercera generación y tiene un rendimiento FP8 superior al TPU de séptima generación de Google”.

Respecto a la distribución y uso de este chip, explicaron que: “Está desplegado en nuestra región de centros de datos US Central, cerca de Des Moines, Iowa, con la región de centros de datos US West 3 cerca de Phoenix, Arizona, y futuras regiones que vendrán después”.

El Servicio de Impuestos Internos (SII) publicó en su sitio web la tasación de los vehículos livianos y pesados para este 2026.