Google presentó este lunes un anuncio de “vanguardia” en materia de inteligencia artificial. Se trata de un nuevo modelo de lenguaje que apodaron “Gemini” y, aseguran, es el más avanzado que han desarrollado en su historia.

Gemini 1.0, la primera versión de este modelo, cuenta con tres aristas distintas:

-

Gemini Ultra: el modelo de mayor capacidad y tamaño para tareas complejas

-

Gemini Pro: el mejor modelo para escalar una amplia gama de tareas

-

Gemini Nano: el modelo más eficiente para tareas en dispositivos móviles.

¿Qué es Gemini?

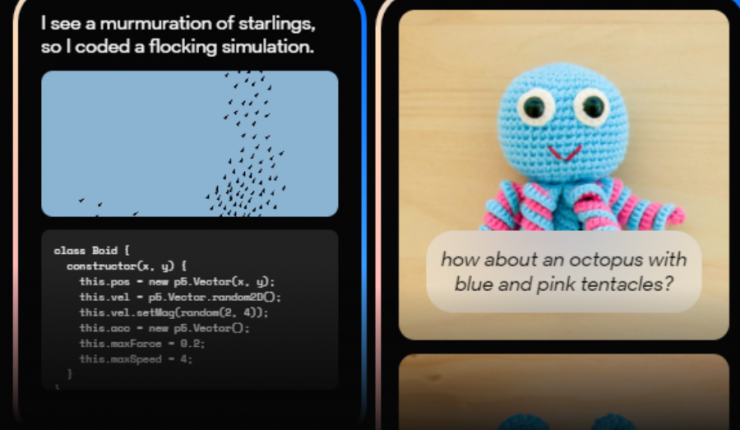

Gemini es un modelo de inteligencia artificial multimodal que puede generar, comprender, operar y combinar a la perfección diferentes tipos de información, incluyendo texto, imágenes, audios, videos e incluso lenguajes de programación.

Google asegura que este es su modelo más flexible hasta el momento, capaz de ejecutarse eficientemente en cualquier dispositivo, desde móviles hasta centros de datos.

“Gemini mejorará significativamente la forma en la que los clientes corporativos y desarrolladores construyen y escalan con IA”, señaló la firma.

Cambio al estándar

Hasta el momento, el método estándar para crear modelos multimodales consistía en entrenar componentes separados para distintas áreas, y luego unirlos para imitar a grandes rasgos algunas de sus funciones.

A veces, estos modelos pueden ser buenos en determinadas tareas, como la descripción de imágenes, pero tienen algunas limitaciones cuando se trata de razonamiento conceptual, contextual o complejo.

Gemini es un modelo de IA multimodal de forma nativa, es decir, previamente entrenado en diferentes modalidades, perfeccionado para poder mejorar su eficacia.

Puede comprender y razonar sin problemas todo tipo de entradas mucho mejor que los modelos existentes.

“Sus capacidades son de vanguardia en casi todos los ámbitos”, aseguran.

Gemini 1.0 se encontrará disponible en una serie de productos y plataformas:

Para usuarios

-

A partir de hoy, Bard con Gemini Pro estará disponible en inglés en más de 170 países y territorios. Esta herramienta será más capaz en cuestiones como comprender y resumir, razonar, generar ideas, escribir y planificar. Esta es la mayor mejora de calidad de Bard desde su lanzamiento.

-

También se llevará “Gemini” a Pixel. Pixel 8 Pro es el primer teléfono inteligente diseñado para ejecutar Gemini Nano que impulsa nuevas funciones como resumir en la aplicación de Grabadora e implementar Redacción Inteligente en Gboard, comenzando con WhatsApp, y el próximo año se incluirán más aplicaciones de mensajería.

-

Como parte de las exhaustivas verificaciones de confianza y seguridad de Gemini Ultra, Google lo pondrá a disposición de clientes, desarrolladores, socios y expertos en seguridad y responsabilidad seleccionados para que experimenten y den su opinión antes de lanzarlo para desarrolladores y clientes corporativos, a principios del año que viene.

-

A principios de 2024, la compañía lanzará Bard Advanced: una nueva experiencia de IA avanzada mediante la que podrá acceder a los mejores modelos y capacidades, comenzando por Gemini Ultra.

-

Y ya estamos trabajando para que Gemini potencie otros productos como Search, Chrome, nuestros anuncios y Duet AI.

Para clientes y desarrolladores

-

A partir del 13 de diciembre, desarrolladores y clientes podrán acceder a Gemini Pro a través de la API de Gemini en Google AI Studio y en Vertex AI.

-

Ai Studio es una herramienta web gratuita que ayuda a desarrolladores a prototipar y lanzar aplicaciones de manera rápida y sencilla.

-

Vertex AI, por su parte, permite una personalización de Gemini con control total sobre los datos y suma los beneficios de Google Cloud como seguridad, privacidad, gobernanza de datos y compliance de nivel corporativo.

-

-

Los desarrolladores de Android podrían crear aplicaciones sobre Gemini Nano, nuestro modelo más eficiente para dispositivos móviles, a través de AI Core.

Etapa de pruebas

La versión Ultra de Gemini se encuentra ahora en etapa de pruebas de seguridad con socios externos y será abierta a un grupo de usuarios, desarrolladores y clientes para una experimentación temprana a comienzos del próximo año.

Deja tu comentario